Frequenzanalyse enttarnt Fake-Bilder

Forscherinnen und Forscher der Ruhr-Universität Bochum haben ein neues Verfahren entwickelt, wie sich manipulierte Fotos, sogenannte Deep-Fake-Bilder, enttarnen lassen. Den Code haben sie ins Netz gestellt.

Foto: RUB, Lehrstuhl für Systemsicherheit

Fake-News, der Begriff ist in aller Munde. Schon lange bevor der Begriff durch den US-Präsident Donald Trump geprägt wurde, haben sich ganz seriöse Presseagenturen nicht nur mit gefälschten Nachrichten, sondern auch mit täuschend echten, computermanipulierten Fotos herumschlagen müssen: Ist real, was uns geliefert wird, lautet die Frage. Deep-Fake-Bilder nennt man diese Fotos, wenn sie mithilfe von maschinellem Lernen erzeugt wurden und für Menschen kaum von realen Fotos zu unterscheiden sind.

Ein Team von Expertinnen und Experten der Ruhr-Universität (RUB) hat gestern auf der „International Conference on Machine Learning“ (ICML), eine Methode auf Basis von Frequenzanalysetechniken vorgestellt, die in Zukunft hilft, diese Frage zu beantworten. Das Team des Horst Görtz Instituts für IT-Sicherheit der Ruhr-Universität Bochum und des Exzellenzclusters „Cyber Security in the Age of Large-Scale Adversaries“ (Casa) hat eine neue Methode entwickelt, die die Motive im Frequenzbereich analysiert, eine klassische Technik der digitalen Signalverarbeitung.

Zwei Algorithmen erzeugen ein Deep-Fake-Foto

Deep-Fake-Bilder lassen sich mithilfe von sogenannten Generative Adversarial Networks, kurz GANs, erzeugen. Für ein Bild arbeiten zwei Algorithmen zusammen: Der erste erstellt basierend auf gewissen Inputdaten zufällige Bilder. Der zweite testet, ob das Bild gefälscht ist oder nicht. „Enttarnt er das Bild als Fake, gibt er dem ersten Algorithmus das Kommando, das Bild zu überarbeiten – so oft, bis er es nicht mehr als Fälschung erkennt“, so die RUB in einer Mitteilung.

GANs hätten in den vergangenen Jahren dazu beigetragen, dass Deep-Fake-Bilder immer authentischer geworden seien, so die RUB. „Gerade in Zeiten von Fake-News kann es ein Problem sein, wenn Nutzerinnen und Nutzer computergenerierte Motive und Originale nicht auseinanderhalten können“, sagt Thorsten Holz, Inhaber des Lehrstuhls für Systemsicherheit am Horst Görtz Institut für IT-Sicherheit. Er und sein Team laden Userinnen und User ein, selbst zu testen, wie schwierig es ist, Deep-Fakes von der Realität zu unterscheiden. Auf der Website www.whichfaceisreal.com lässt sich das selbst testen.

Frequenzanalyse offenbart Fake-Bilder

Für ihre Analyse nutzten die Bochumer Wissenschaftlerinnen und Wissenschaftler die Datensätze, die auch der oben genannten Seite „Which face is real“ zugrunde liegen. Nicht, dass es bisher keine Verfahren gegeben hätte, Deep-Fake-Bilder zu untersuchen, so die RUB, bisher seien dies aber aufwendige statistische Verfahren gewesen. Die Bochumer Gruppe wählte für die Analyse einen anderen Ansatz.

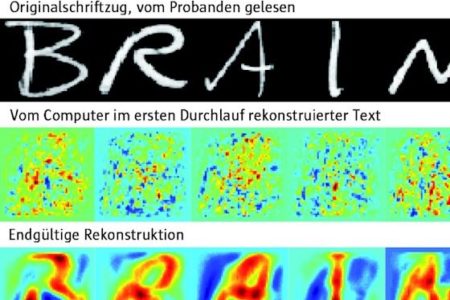

Bildinformationen lassen sich generell mathematisch umwandeln und im Frequenzbereich darstellen mithilfe trigonometrischer Funktionen, mit denen die Physik ganz generell auch Schwingungen beschreibt. Das RUB-Team nutzt dazu die Diskrete Kosinustransformation.

Fake-Bilder verraten sich durch Artefakte

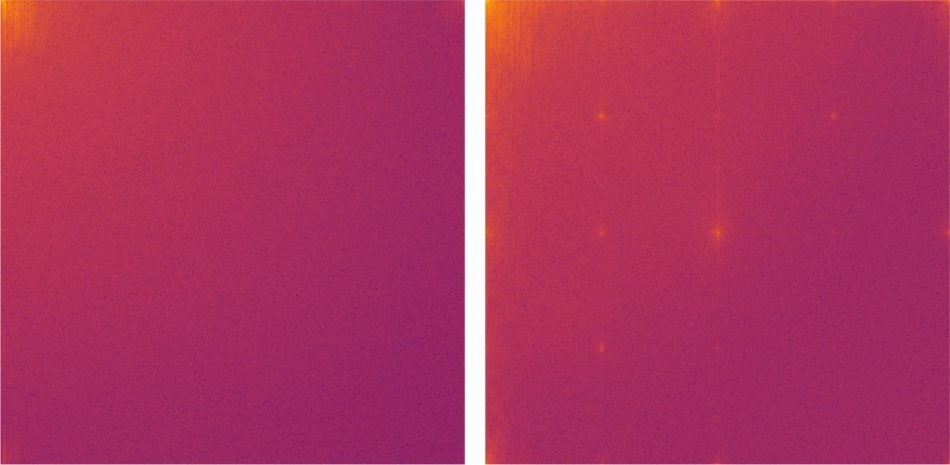

Natürliche Bilder bestehen größtenteils aus niederfrequenten Funktionen. Die Analyse zeigte jetzt, dass von GANs erzeugte Bilder verschiedene Arten von Artefakten im hochfrequenten Bereich aufweisen. So wird in der Frequenzdarstellung von gefälschten Bildern beispielsweise eine typische Gitterstruktur sichtbar (s. Bild).

„Unsere Experimente haben ergeben, dass diese Artefakte nicht nur bei GANs auftreten, sondern dass es sich um ein strukturelles Problem aller Deep-Learning-Algorithmen handelt“, erklärt Holz‘ wissenschaftlicher Mitarbeiter Joel Frank. „Wir gehen davon aus, dass man anhand der in unserer Studie beschriebenen Artefakte immer erkennt, ob es sich um ein Deep-Fake-Bild handelt, das mit maschinellem Lernen erstellt wurde“, ergänzt Frank. Die Frequenzanalyse sei somit ein effektiver Weg, computergenerierte Bilder automatisiert zu erkennen.