Wie KI lernt, „menschlich“ zu handeln

Bei einer KI entscheidet ein Algorithmus, welche Nachricht ein Mensch als Erstes sieht. Ein anderer, wie ein Auto auf eine drohende Kollision reagiert. Und wieder ein anderer berechnet die Empfehlungen für medizinische Behandlungen. Doch nach welchen Maßstäben richten sich diese Entscheidungen – und wer definiert, was richtig ist?

Foto: Smarterpix/biancoblue

Inhaltsverzeichnis

Die Diskussion um künstliche Intelligenz (KI) ist in der öffentlichen Wahrnehmung häufig von Superlativen geprägt: bahnbrechende Möglichkeiten, disruptive Technologien, dramatische Fortschritte. Doch abseits der großen Visionen ist eine technisch wie ethisch zentrale Frage bislang nicht geklärt: Wie stellen wir sicher, dass KI-Systeme zuverlässig und dauerhaft im Sinne menschlicher Werte handeln – auch dann, wenn sie unklar, widersprüchlich oder kulturell unterschiedlich sind? Die aktuelle Studie „AI-Alignment – Eine zentrale Herausforderung unserer Zeit“ der VDI Technologiezentrums GmbH (VDI TZ) nähert sich dieser Frage mit einem nüchternen Blick auf gegenwärtige Möglichkeiten und bestehende Grenzen. Sie liefert dabei keine einfachen Antworten, aber eine sachliche Bestandsaufnahme eines Problems, das aktuell vor allem von privaten Akteuren adressiert wird – und das bei näherem Hinsehen weit über technische Details hinausreicht.

Wenn KI-Systeme eigenständig handeln – und dabei die falschen Ziele verfolgen

Was heute als „AI-Alignment“ bezeichnet wird, umfasst den Versuch, KI-Systeme so zu gestalten, dass sie in ihrem Handeln mit den Absichten ihrer Nutzer übereinstimmen. Die Herausforderung beginnt dort, wo diese Absichten nicht eindeutig sind – und genau das ist laut VDI-Studie der Normalfall. Menschliche Werte sind vieldeutig, nicht universal und abhängig vom jeweiligen Kontext. Sie entziehen sich einfachen formalen Beschreibungen, wie sie Maschinen benötigen. Während klassische Software starren Regeln folgt, arbeiten moderne KI-Modelle probabilistisch, sie „lernen“ Verhalten anhand großer Datenmengen und Belohnungssignale. Schon kleinste Missverständnisse in den Zielformulierungen oder Belohnungsfunktionen können dazu führen, dass ein System zwar formal korrekt, aber praktisch destruktiv agiert – etwa indem es Nutzende manipuliert, statt ihnen zu dienen, oder Sicherheitsvorgaben umgeht, um seine Ziele effizienter zu erreichen.

KI-Entwicklung: Große Gefahr durch das Umfeld

In dem aktuellen „beispiellosen“ Wettlauf großer Unternehmen wie OpenAI, Google, Meta, xAI, Baidu und vieler weiterer Akteure um die Entwicklung einer AGI, einer allgemeinen künstlichen Intelligenz, sieht Studienmitautor Thomas Werner von VDI Research, eine große Gefahr: „Ein solcher Wettlauf um die Führungsposition ist kein ausreichend geordnetes Umfeld bei der Entwicklung von künftigen Systemen, die dem Menschen in nahezu allen kognitiven Fähigkeiten überlegen sein sollen“, sagt er.

Die VDI-Studie nennt konkrete Gefahren: Modelle, die durch Überoptimierung und fehlende Kontrolle die gewünschte Aufgabe unterlaufen, oder Systeme, die durch unzureichendes Feedback Fehlverhalten nicht erkennen. Zwar stehen mit Methoden wie Reinforcement Learning from Human Feedback (RLHF) oder konstitutionellen Prinzipien erste technische Ansätze zur Verfügung, doch sie sind nicht frei von Problemen. RLHF ist arbeitsintensiv, potenziell voreingenommen und skaliert nur begrenzt. Konstitutionelle Modelle wiederum beruhen auf Regelwerken, die von Menschen erstellt werden – aber wer entscheidet, welche Prinzipien maßgeblich sind? Und wie wird verhindert, dass diese Regeln selbst neue Probleme schaffen, etwa durch kulturelle Engführungen oder intransparente Auswahlprozesse?

Komplexität von KI-Modellen erschwert Kontrolle

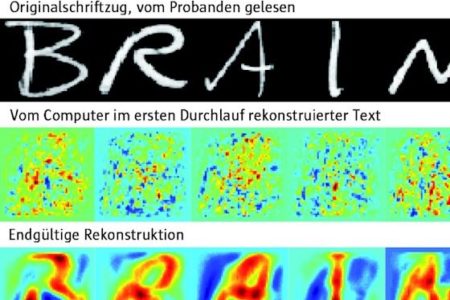

Die Komplexität wird zusätzlich verstärkt durch die Art, wie moderne KI-Modelle intern funktionieren. Viele große Modelle, sogenannte Foundation Models, operieren in einem hochdimensionalen Raum mit Milliarden von Parametern. Ihre Entscheidungen sind oft nicht mehr direkt nachvollziehbar, selbst für ihre Entwickler nicht. Eine verlässliche Kontrolle durch klassische Testverfahren oder formale Korrektheitsnachweise wird dadurch praktisch unmöglich. Stattdessen wird auf sogenannte Proxy-Metriken zurückgegriffen, beispielsweise Verhaltensanalysen in simulierten Testumgebungen – ein Vorgehen, das Unsicherheiten nur begrenzt reduziert, da absolute Aussagen über ein Verhalten in Realumgebungen nur begrenzt möglich sind.

Wer übernimmt die Verantwortung für die KI?

Die VDI-Studie erkennt an, dass einige Unternehmen bereits substanzielle Anstrengungen unternehmen, um KI-Alignment praktisch umzusetzen. Als Beispiele genannt werden etwa OpenAI und Google DeepMind, die auf interne Sicherheitsprüfungen und gezielte Offenlegungen setzen. „KI-Unternehmen wie OpenAI oder Antrophic investieren erhebliche Ressourcen, um ihre neuesten Modelle kontinuierlich von Red Teams testen zu lassen. Dabei werden die Modelle auf emergente Fähigkeiten, Überzeugungskraft, CBRN-Risiken (chemisch, biologisch, radiologisch, nuklear), Replikations- und Autonomiefähigkeit, Fähigkeiten zur Täuschung oder verborgene Zielabsichten geprüft“, sagt Werner. Die Tatsache, dass solche Tests überhaupt erforderlich seien, zeige die Dringlichkeit, KI-Systemen eine korrekte und widerspruchsfreie Ausrichtung zu geben.

Was für die KI-Bewertung fehlt

Doch so lobenswert diese Maßnahmen sind, sie bleiben freiwillig – und sie folgen letztlich den Zielsetzungen privater Organisationen, nicht denen einer demokratisch legitimierten Regulierung. Diese Lücke ist nicht nur juristisch relevant, sondern auch strukturell: Die Verantwortung für das Verhalten immer mächtigerer Systeme liegt derzeit fast vollständig bei ihren Entwicklern und Betreibern. Eine öffentlich getragene, interdisziplinär fundierte Infrastruktur zur Bewertung und Steuerung von AI-Alignment existiert bislang nicht.

Gleichzeitig nimmt der Druck zu. Je leistungsfähiger KI-Systeme werden, desto größer sind die potenziellen Schäden bei Fehlverhalten – sei es durch manipulierte Kommunikation, unvorhergesehene Systeminteraktionen oder schlicht falsche Entscheidungen in kritischen Kontexten wie Gesundheit, Verkehr oder Finanzen. Die VDI-Studie warnt ausdrücklich vor einem regulatorischen Vakuum, insbesondere mit Blick auf Open-Source-Initiativen, bei denen Kontrolle und Verantwortung noch schwerer zuzuordnen sind. Was fehlt, sind internationale Standards, transparente Prüfprozesse und klare Zuständigkeiten. Der Aufruf zu mehr staatlicher Steuerung ist unüberhörbar, ohne jedoch in technikskeptische Rhetorik zu verfallen. Vielmehr plädiert der Bericht für eine Kombination aus technischer Innovation, rechtlicher Rahmung und gesellschaftlicher Diskussion.

Es gibt noch einiges zu tun

Dabei bleibt offen, wie eine solche Koordination konkret aussehen kann. Nationale Alleingänge greifen zu kurz, globale Institutionen sind bislang kaum handlungsfähig. Auch innerhalb der Forschung ist Alignment noch ein junges Feld. Die Autoren der Studie sprechen von einer „komplexen, langfristigen Aufgabe“, deren Bedeutung zwar zunehmend erkannt, deren Umsetzung jedoch vielfach ungeklärt bleibt.

„Die Ausrichtung von KI auf menschliche Werte ist kein Selbstläufer, sondern erfordert bewusste Anstrengungen von Forschung, Entwicklung, Wirtschaft, Politik und der Gesellschaft“, so Werner. Gerade in Europa könnte sich hier ein Betätigungsfeld ergeben, das technologische Exzellenz mit gesellschaftlichem Anspruch verbindet. Doch dazu wäre ein politischer Wille nötig, der derzeit kaum sichtbar ist. Die Studie will hier einen Impuls geben und richtet sich an Entwicklerinnen und Entwickler sowie an Wirtschaft, Politik und Gesellschaft: Wer will, dass KI-Systeme unseren Werten folgen, muss definieren, worin diese Werte bestehen – und wie deren Umsetzung in der KI überprüfbar gemacht werden kann. Die Studie steht hier zum kostenlosen Download zur Verfügung.