Roboter sehen wie Menschen: DFKI stellt neue Technologie vor

Damit Roboter künftig Objekte im Kontext besser bewerten können, haben Forscher des DFKI eine Lösung entwickelt. Im Detail wird sie demnächst auf einer Konferenz in den USA vorgestellt.

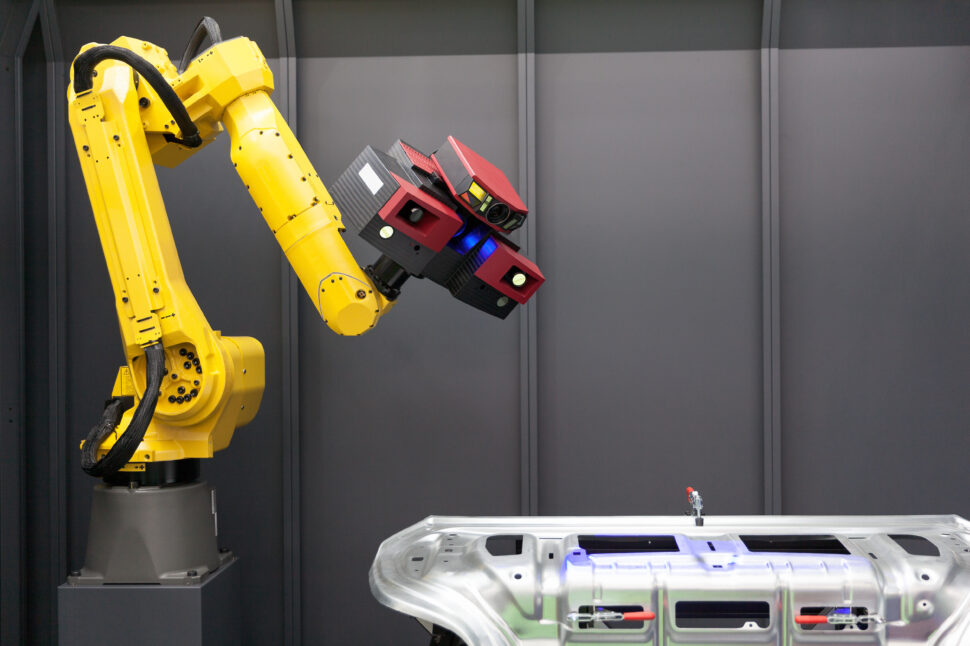

Foto: panthermedia.net/ Mihajlo Maricic

Roboter tun sich in Alltagsumgebungen von Menschen oft schwer. Der Grund: Menschen bewerten Gesehenes in einem Kontext. Erkennen sie beispielsweise ein gefülltes Glas, dann rechnen sie damit, dass bei unsanften Bewegungen Flüssigkeit überschwappen kann. Damit auch Maschinen lernen, sich in unserer Lebenswelt visuell zu orientieren, haben Wissenschaftler am Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) den Multi-Key-Anchor & Scene-Aware Transformer for 3D Visual Grounding (MiKASA) entwickelt. Mit maschineller Mustererkennung ermöglicht er es, komplexe räumliche Abhängigkeiten und Merkmale von Objekten im dreidimensionalen Raum zu identifizieren und semantisch zu begreifen. Auf der diesjährigen Conference on Computer Vision and Pattern Recognition (CVPR) in Seattle, USA, stellen die Forschenden aus der Abteilung Augmented Vision diese Lösung nun vor.

Lernende Roboter: Mustererkennung stellt Kontext bei Objekten her

Menschen lernen bereits beim Spracherwerb, Dinge in einen Zusammenhang zu bringen. Das geht über die reine Sprache hinaus und hilft z. B. eine Intention oder Referenz nachzuvollziehen und diese mit einem Objekt in unserem Lebensumfeld in Verbindung zu bringen. Roboter haben diese Fähigkeiten bisher nicht, können sie aber erlernen. Weltweit gibt es dazu Forschungsansätze, die bisher aber nur ansatzweise an die menschlichen Fähigkeiten herankamen.

Lesetipp: Humanoider Roboter von Figure AI zeigt natürliche Interaktion dank ChatGPT

Das ändert sich gerade und das DFKI will dabei mit MiKASA eine wesentliche Rolle spielen. Durch einen „szenenbewussten Objekterkenner“ können damit laut den Forschenden jetzt auch Maschinen Rückschlüsse aus der Umgebung eines Referenzobjekts ziehen – und das Objekt so zielsicher erkennen sowie korrekt definieren. Sie bewerten Dinge also kontextabhängig und erlangen damit ein nuanciertes Verständnis ihrer Umgebung.

Eine Frage der Perspektive: Tücken bei der Lokalisierung von Objekten

Die Tücken liegen aber im Detail, wenn es beispielsweise gilt, relative räumliche Abhängigkeiten zu verstehen. „Der Stuhl vor dem blauen Monitor“ kann aus einer anderen Perspektive „der Stuhl hinter dem Monitor“ sein. Damit der Maschine klar wird, dass es sich bei beiden Stühlen tatsächlich um ein und dasselbe Objekt handelt, arbeitet das Programm mit einem sogenannten „Multi-Key-Anchor Concept“. Das übermittelt die Koordinaten von Ankerpunkten im Blickfeld in Relation zu dem Zielobjekt und bewertet die Wichtigkeit von nahen Objekten anhand von Textbeschreibungen.

Semantische Rückbezüge können dann helfen, das Objekt zu lokalisieren. Typischerweise ist ein Stuhl in Richtung eines Tisches platziert oder steht mit der Rückseite an einer Wand. Die Anwesenheit eines Tisches oder einer Wand definiert damit indirekt die Ausrichtung des Stuhls.

Trefferquote bei Objekterfassung um 10 % gesteigert

Nach Angaben des DFKI erreicht MiKASA durch die Verknüpfung von Sprachmodellen, gelernter Semantik und der Wiedererkennung der Objekte im realen dreidimensionalen Raum eine Genauigkeit von bis zu 78,6 %. Im Vergleich zu der besten bisherigen Technologie in diesem Bereich konnte die Trefferquote zur Objekterfassung damit um rund 10 % gesteigert werden.

Visuelle Informationen der Umgebung liefern dem Roboter zahlreiche Sensoren, deren Daten zu einem Gesamteindruck zusammengeführt werden. Wie bei den menschlichen Augen kommt es dabei zu Überlappungen von Sehbereichen. Um aus der Vielzahl von Daten ein stimmiges Bild zu generieren, haben die Forschenden am DFKI deshalb das „SG-PGM“ (Partial Graph Matching Network with Semantic Geometric Fusion for 3D Scene Graph Alignment and Its Downstream Tasks) entwickelt. Die Ausrichtung zwischen sogenannten dreidimensionalen Szenenvisualisierungen (3D scene graphs) ist Grundlage für eine Vielzahl von Anwendungen. Sie unterstützt beispielsweise bei der „Punktwolkenregistrierung“, bei der Punkte von verschiedenen Laserscannern zusammengeführt werden. Das hilft Robotern bei ihrer Navigation.

Damit das auch in dynamischen Umgebungen mit etwaigen Störquellen gelingt, verknüpft SG-PGM die Visualisierungen mit einem neuronalen Netzwerk. Das Programm verwertet dabei die geometrischen Elemente wieder, welche durch die Registrierung erlernt wurden, und assoziiert die gruppierten geometrischen Punktdaten mit den semantischen Merkmalen auf Knotenebene.

Computer Vision: Technologie für Roboter wird auf der CVPR 2024 vorgestellt

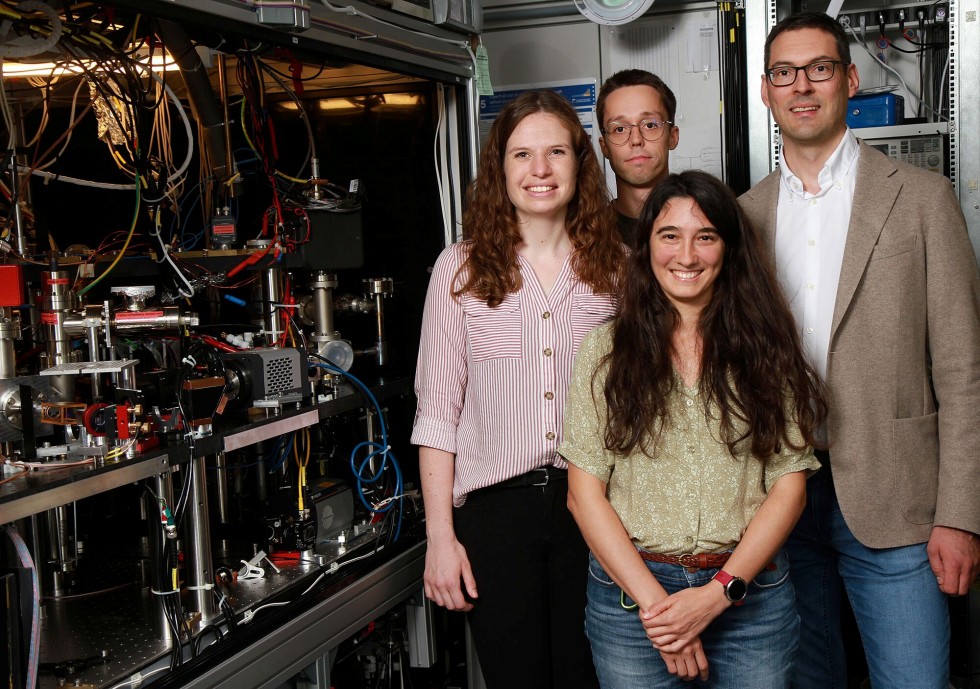

Die CVPR 2024 wird vom 17. Juni bis 21. Juni am Seattle Convention Center stattfinden und zählt zu den bedeutendsten Veranstaltungen im Bereich der maschinellen Mustererkennung. Mit insgesamt sechs unterschiedlichen Abhandlungen will das Team von Didier Stricker, Forschungsbereichsleiter von Augmented Vision am DFKI, unter anderem Technologien präsentieren, welche Objekte im dreidimensionalen Raum anhand variabler sprachlicher Beschreibungen identifizieren und die Umgebung ganzheitlich mit Sensoren erfassen und abbilden können.